Apple julkisti reilu viikko sitten tulevat, lapsiin liittyvät suojaominaisuutensa, joista niin sanottu ”lapsipornoskannaus” on sittemmin aiheuttanut melkoisen kohun.

Applen on nähty uudella ratkaisullaan loukkaavan käyttäjien yksityisyyttä – ja samalla ovat heränneet pelot, mitä muuta lasten seksuaaliseen hyväksikäyttöön liittyvän materiaalin jälkeen Apple-laitteista voitaisin seuraavaksi alkaa skannata esimerkiksi tiettyjen valtioiden vaatimuksista.

Eilen Applen ohjelmistokehityksen johtaja Craig Federighi myös myönsi, että Apple teki uusien suojaominaisuuksiensa julkistamisen kanssa yksinkertaisen virheen kertoessaan kahdesta samankaltaisesta, mutta kuitenkin erilaisesta toiminnosta samaan aikaan, mikä on voinut johtaa väärinkäsityksiin siitä miten lasten seksuaalista hyväksikäyttöä olevan materiaalin tarkastaminen todella tarkoittaa.

MAINOS (ARTIKKELI JATKUU ALLA)

Nyt Apple on kertonut osana uutta asiakirjaa muutamista lisäyksityiskohdista, joiden tarkoituksena on vastata esiin nousseisiin huoliin. Alla aluksi kertaus toiminnosta, ja sen jälkeen tietoa Applen esittelemistä tarkennuksista.

Tästä Applen ”lapsipornoskannauksessa” on kyse

Applen esittelemä kuvien tarkastaminen lasten seksuaaliseksi hyväksikäytöksi määriteltyjen materiaalien osalta liittyy Applen iCloud-pilvipalveluun.

Kuvien tarkastus tapahtuu kuitenkin käyttäjän laitteessa, ei Applen pilvipalvelussa.

MAINOS (ARTIKKELI JATKUU ALLA)

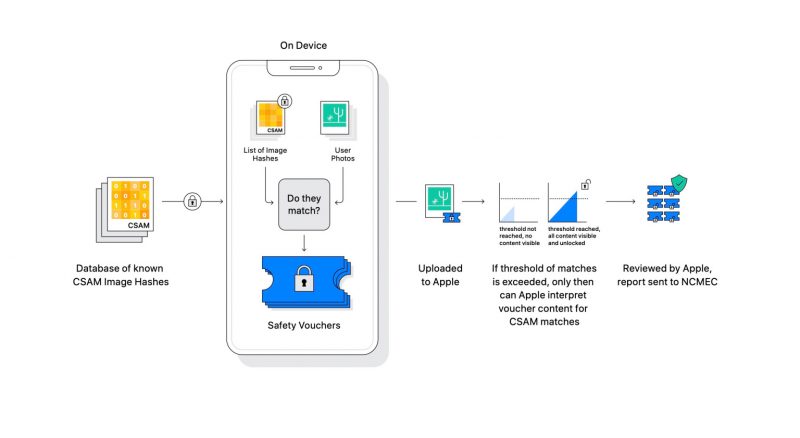

iCloudiin tallennettavien kuvien tarkistamisessa kuvista luodaan neuralMatch-algoritmilla muodostettavia tunnisteita – eli käytännössä merkkijonoja – ja niitä verrataan laitteeseen ladattavaan esimerkiksi Yhdysvaltojen kansallisen kadonneiden ja hyväksikäytettyjen lasten keskuksen (NCMEC, National Center for Missing and Exploited Children) ylläpitämään CSAM-tietokantaan perustuvaan tietokantaan tunnisteita kuvista, jotka on määritelty lasten seksuaaliseksi hyväksikäytöksi.

iCloud-tarkistustoiminto ei siis kuvaa skannaamalla tunnista kuvista niiden sisältämiä asioita, vaan se vain vertaa kuvista algoritmilla muodostettuja tunnisteita jo tiedossa olevien, eli jostakin löydettyjen tai jossakin jaettujen, lasten seksuaaliseksi hyväksikäytöksi määriteltyjen kuvien (CSAM) tunnisteisiin. Jos nämä täsmäävät riittävällä tarkkuudella, eli laitteesta näyttäisi löytyvän jo entuudestaan lasten seksuaaliseksi hyväksikäytöksi määritelty kuva, kirjaa toiminto tästä tiedon ylös.

Apple ei saa tietää mahdollisista täsmäävistä kuvista mitään ennen kuin tietty määritelty vähimmäisraja lasten seksuaaliseksi hyväksikäytöksi määriteltyä materiaalia saavutetaan. Käytännössä siis vaikkapa vain yksittäinen kuva ei vielä aiheuta Applelle näkyvää ilmoitusta. Vasta, kun raja ylittyy, käyttäjätilistä ilmoitetaan Applelle ja se saa tiedon CSAM-tietokantaan nähden syntyneistä osumista, jonka jälkeen se manuaalisesti vahvistaa osumat, estää käyttäjätilin käytön ja raportoi asian esimerkiksi Yhdysvalloissa NCMEC-keskukselle.

Applen mukaan tarkistusraja on asetettu erittäin korkealle tarkkuudelle, mikä varmistaa, että on olemassa alle yhden suhde biljoonaan mahdollisuus virheellisestä käyttäjätilin liputtamisesta Applen henkilöstön tarkistettavaksi.

MAINOS (ARTIKKELI JATKUU ALLA)

Kuvien tarkistustoiminto liittyy Applen iCloud-pilvipalveluun, eikä tarkistusta suoriteta, mikäli iCloud-kuvakirjaston on kytkenyt pois käytöstä. Halutessaan koko tarkastuksesta pääsee siis helposti eroon, ja käyttäjän laite on edelleen täysin yksityinen, mikäli iCloudia ei valitse käyttöön.

Aluksi CSAM-tarkastus on lisäksi tulossa käyttöön vain Yhdysvalloissa uusien iOS ja iPadOS 15 -käyttöjärjestelmäversioiden yhteydessä.

Nämä yksityiskohdat Apple nyt julkaisi huolien lieventämiseksi

Osana sitä Apple on kertonut, että sen järjestelmä tulee olemaan kolmansien osapuolten auditoitavissa eli toiminnaltaan tarkastettavissa.

MAINOS (ARTIKKELI JATKUU ALLA)

Lisäksi Applen mukaan se tulee julkaisemaan verkkosivuillaan artikkelin, joka sisältää salatun CSAM-tietokannan tunnistetietojen tarkistussumman. Tätä voi verrata tarkistussummaan omassa laitteessa varmistaen näin tietokannan asianmukaisuuden ja koostumisen vain järjestelmään osallistuvien lasten turvallisuutta ajavien organisaatioiden ylläpitämistä seksuaaliseksi hyväksikäytöksi määriteltyjen materiaalien tunnisteista.

Yhtenä tärkeänä seikkana Apple on ottanut nyt kantaa mahdollisuuteen, että osaksi CSAM-tietokantaa voitaisiin ujuttaa jotakin muuta materiaalia kuin lasten seksuaalista hyväksikäyttöön liittyvää. Tämä voisi mahdollistaa joidenkin muiden kuvien löytymisen skannaamisen laitteista, mikä on ollut yksi merkittävä pelko Applen esittelemässä ratkaisussa.

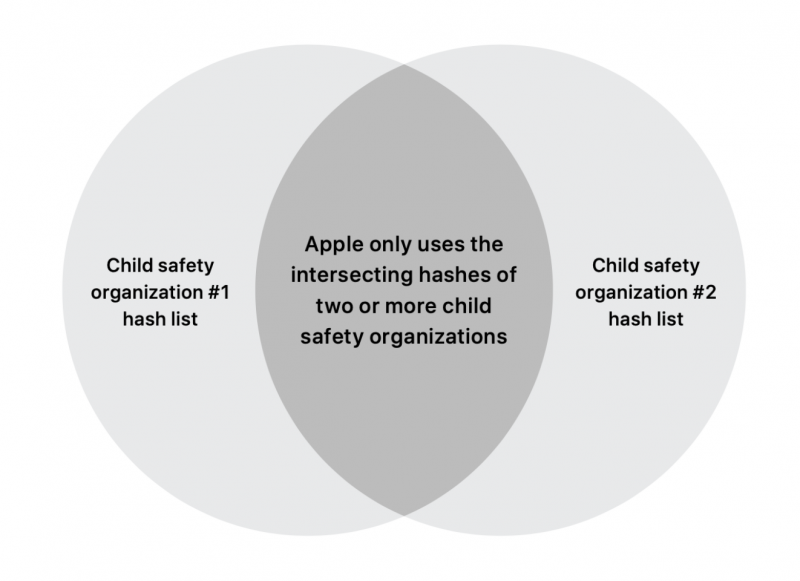

Applen mukaan se tulee toimimaan jatkossa ainakin kahden lasten turvallisuutta ajavan organisaation kanssa muodostaakseen CSAM-tunnisteiden tietokannan, ja nämä kaksi organisaatiota eivät ole saman valtion / hallinnon alaisia. Osaksi Applen yhdistettyä tietokantaa tulevat tunnisteet vain kuvista, jotka löytyvät ainakin kahden organisaation toimittamista tietokannoista. Muut jätetään huomiotta, eikä iCloudiin tallennettavia kuvia näin ollen tarkasteta niiden perusteella.

Applen tunnistetietokanta muodostetaan ainakin kahden organisaation itsenäisesti toimittamista tunnisteista. Näin yksittäinen taho ei voi ujuttaa mukaan ylimääräistä.

Lisäksi Apple on vahvistanut osana uutta asiakirjaa, että se aikoo aluksi asettaa vaadittavan löytyvien kuvien määrän 30 kappaleeseen ennen kuin uusi toiminto kertoo mitään tarkastuksen löydöksistä Applelle. Vasta tämän jälkeen Applen henkilöstö käy läpi tapauksen ja ilmoituksen aiheuttaneen kuvamateriaalin ja raportoi tarvittaessa asianmukaisille paikallisille tahoille.

Myös tämä henkilöstön suorittama läpikäynti CSAM-tarkastuksen jälkeen ennen raportointia varmistaa Applen mukaan omalta osaltaan sitä, etteivät toiminnon perusteella ulkopuoliset pysty suorittamaan muuta seurantaa muuten kuin liittyen seksuaalista hyväksikäyttöä edustavan materiaalin perusteella, sillä se vaatisi kahden erillisen organisaation hakkeroinnin tai kiristämisen (tunnisteiden saamiseksi tietokantaan) lisäksi myös Applen CSAM-materiaalia tarkastavan henkilöstön kiristämistä muista kuin lasten seksuaaliseen hyväksikäyttöön liittyvien materiaalien löydöksistä eteenpäin raportoimiseksi.

Mainos: Noin 1 600 000 tuotteen hintavertailu ja hintaseuranta - katso Hinta.fistä mistä saat halvimmalla

Salasana hukassa?

Etkö ole vielä rekisteröitynyt? Rekisteröidy tästä »